Apple kündigt neue Funktionen für seine Geräte an, die bei der Bekämpfung von Kindesmissbrauch helfen.

Apple arbeitet weiterhin an der Sicherheit und hat kürzlich ein neues System dafür entwickeltAufdeckung von Material mit Aspekten des Kindesmissbrauchs.

Apple gegen Kindesmissbrauch

Laut einem zuvor erwähnten Bericht würde Apple dies bekannt gebenein neues Tool mit Hashing-Algorithmenzur fotografischen Erkennung von Inhalten im Zusammenhang mit Kindesmissbrauch. Das alles durchein neues Systemdie auf dem Gerät des Benutzers installiert wird und Bilder mit illegalem Material vergleicht, um Übereinstimmungen zu finden.

Dieses neue System würde mit digitalen Fingerabdrücken funktionieren, die nicht gegen die derzeit vom Unternehmen geltenden Datenschutzbestimmungen verstoßen und das Hochladen von Dateien auf iCloud Photos mit dem Ziel beeinträchtigen würdenVerhindern Sie die Ausbreitung und den Schutz von ungeeignetem Material.

Jetzt ist es Realität. Das hat das Unternehmen Apple offiziell bekannt gegebeneine neue Initiativezum Schutz von Kindern auf iPhone, iPad und Mac.„Der Schutz von Kindern ist eine wichtige Verantwortung“. Apple kündigt drei neue Funktionen für diesen neuen Sicherheitsvorsprung an.

CSAM-Erkennung

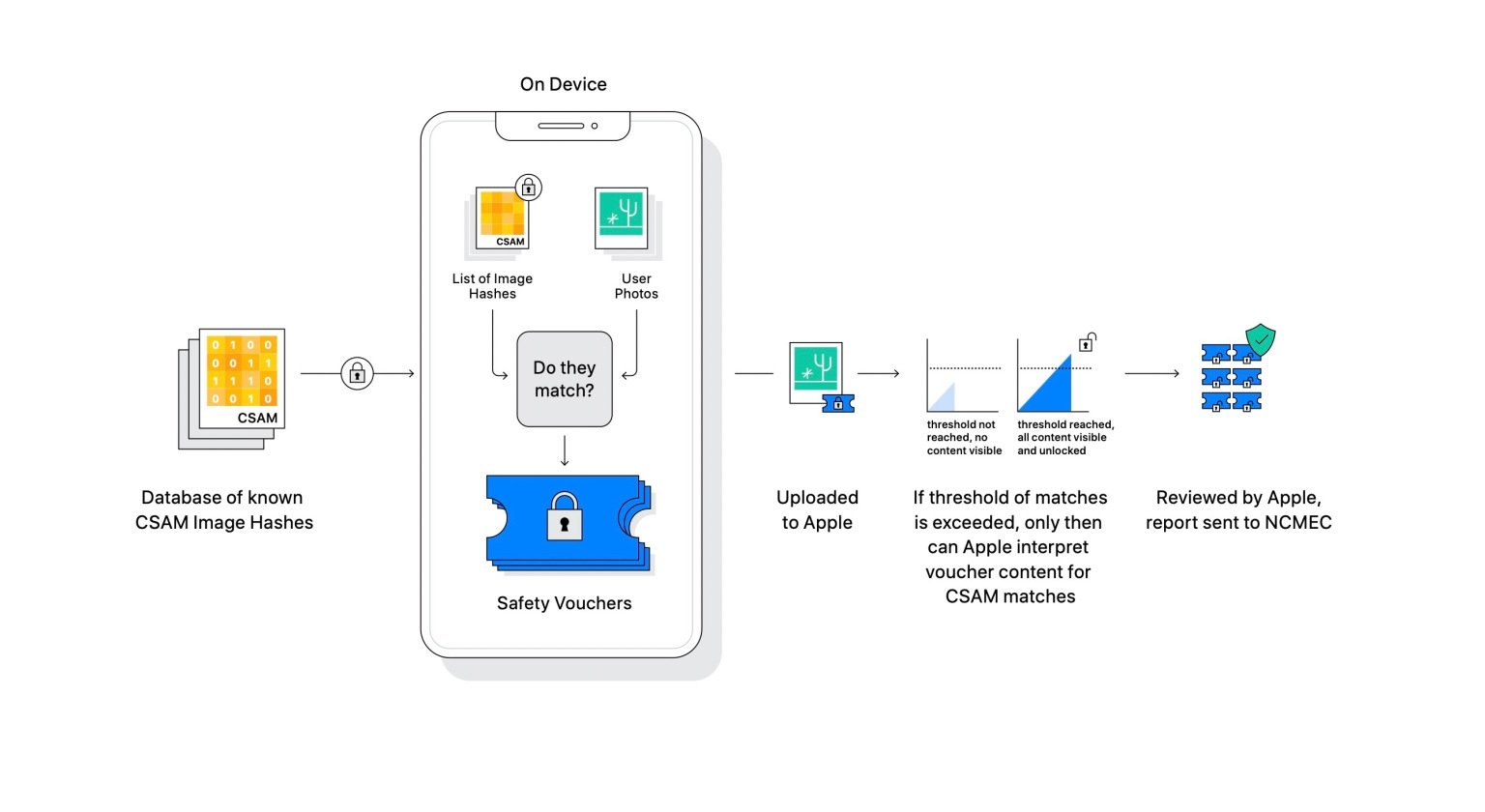

Mit CSAM bezieht sich Apple auf Inhalte, die sexuell eindeutige Aktivitäten mit einem Kind zeigen. Dafür wurde es umgesetzteine neue Erkennungsmethodefür Benutzerinhalte, um durch den oben genannten Hashing-Prozess Übereinstimmungen zu finden und so CSAM-Fälle an das National Center for Missing and Exploited Children melden zu können.

"Bevor ein Bild in iCloud-Fotos gespeichert wird, wird auf dem Gerät ein Vergleichsprozess für dieses Bild mit dem nicht lesbaren Satz bekannter CSAM-Hashes durchgeführt. Dieser Matching-Prozess basiert auf einer kryptografischen Technologie namens „Private Set Intersection“, die ermittelt, ob eine Übereinstimmung vorliegt, ohne das Ergebnis preiszugeben. Mit Private Set Intersection (PSI) kann Apple feststellen, ob ein Bild-Hash mit bekannten CSAM-Bild-Hashes übereinstimmt, ohne etwas über nicht übereinstimmende Bild-Hashes zu erfahren. PSI verhindert außerdem, dass der Benutzer weiß, ob eine Übereinstimmung vorliegt.

Damit kein Fehler vorliegt, nutzt Appleeine neue Technologie namens Threshold, das filtert und sicherstellt, dass die Erkennung korrekt ist und kein falscher CSAM-Befund erstellt werden kann. Nach Angaben von Apple weist das System eine Fehlerquote von weniger als 1 von 1 Milliarde Konten pro Jahr auf.

Die Erkennung erfolgt durch Filtern von Informationen und Vergleichen von Bildern aus einer CSAM-Datenbank und den Bibliotheken des Benutzers.

Nachrichten

Eine der wichtigsten Entwicklungen für die Sicherheit von Minderjährigen sind Nachrichten. Jetzt die Kinder, die habenÜber iCloud mit einer Familie verknüpfte Apple-GeräteSie werden in ihren Nachrichten Warnhinweise enthalten, wenn sie Bilder empfangen oder senden, die möglicherweise sexuell eindeutig sind.

Das ist richtig, jedes Mal, wenn ein Minderjähriger ein möglicherweise sensibles Bild erhält, erscheint es verschwommen und die App sendet sofort eine Warnmeldung. In dieser Warnung wird dem Minderjährigen mitgeteilt, warum dies unangemessen ist und ob er oder sie mit der Einsichtnahme einverstanden ist.Der iCloud-Elternteil erhält eine Benachrichtigung„Um sicherzustellen, dass es dir gut geht.“

Dasselbe passiert, wenn der Minderjährige versucht, ein Foto zu senden, das als unangemessen gilt, weil es sexuell eindeutig ist.

Apple erwähnt, dass das System mit dem automatischen Lernen beginnt, das dabei hilft, sensible Inhalte zu identifizieren, ohne die Ende-zu-Ende-Verschlüsselungsvereinbarung des Dienstes brechen zu müssen, weshalb dies der Grund istGespräche bleiben privat, aber sicherer für Kinder.

Eltern können über die Familie in iCloud mehr Kontrolle über ihre Kinder haben.

Suchen und Siri

Endlich die Siri- und Suchfunktionen von Apple-Gerätenwurden angepasstHilfe zum Thema Kindesmissbrauch anzubieten.

"Apple erweitert außerdem die Anleitung zu Siri und der Suche, indem es zusätzliche Ressourcen bereitstellt, die Kindern und Eltern dabei helfen, online sicher zu bleiben und in unsicheren Situationen Hilfe zu erhalten. Wenn Benutzer beispielsweise Siri fragen, wie sie sexuellen Missbrauch oder Ausbeutung von Kindern oder Kindern melden können, werden sie zu Ressourcen weitergeleitet, die Auskunft darüber geben, wo und wie sie eine Meldung einreichen können.

Siri und Search werden ebenfalls aktualisiert, um einzugreifen, wenn Benutzer nach CSAM-bezogenen Abfragen suchen. Diese Interventionen werden den Benutzern erklären, dass das Interesse an diesem Thema schädlich und problematisch ist, und Partnerressourcen zur Unterstützung bei diesem Thema bereitstellen.

Auch Siri und die Suchfunktion bieten Hilfe und Informationen zum Thema Kindesmissbrauch.

Diese neuen Funktionen werden in den Updates von iOS 15, iPadOS 15 und macOS Monterey implementiert, in den USA eingeführt und erweitertso schnell wie möglichin andere Regionen.

Daran besteht kein Zweifelein großer Schrittfür das soziale Wohlergehen, für die Kontrolle und Betreuung von Minderjährigen, die Geräte nutzen, und etwas, das den Erfolg von Apple, zu dem es heute geworden ist, selbstlos beeinflussen könntedas sechste Unternehmen, das heute das meiste Geld verdient.

Du kannst folgeniPadisiertInFacebook,WhatsApp,Twitter (X)konsultieren oder konsultierenunser Telegram-Kanalum über die neuesten Technologienachrichten auf dem Laufenden zu bleiben.